La entropía se define como la medida cuantitativa de desorden o aleatoriedad en un sistema. El concepto surge de la termodinámica, que se ocupa de la transferencia de energía térmica dentro de un sistema. En lugar de hablar de alguna forma de «entropía absoluta», los físicos generalmente discuten el cambio en la entropía que tiene lugar en un proceso termodinámico específico.

Conclusiones clave: cálculo de la entropía

- La entropía es una medida de probabilidad y el desorden molecular de un sistema macroscópico.

- Si cada configuración es igualmente probable, entonces la entropía es el logaritmo natural del número de configuraciones, multiplicado por la constante de Boltzmann: S = k B ln W

- Para que la entropía disminuya, debe transferir energía desde algún lugar fuera del sistema.

Cómo calcular la entropía

En un proceso isotérmico, el cambio de entropía (delta- S ) es el cambio de calor ( Q ) dividido por la temperatura absoluta ( T ):delta-

S = Q / T

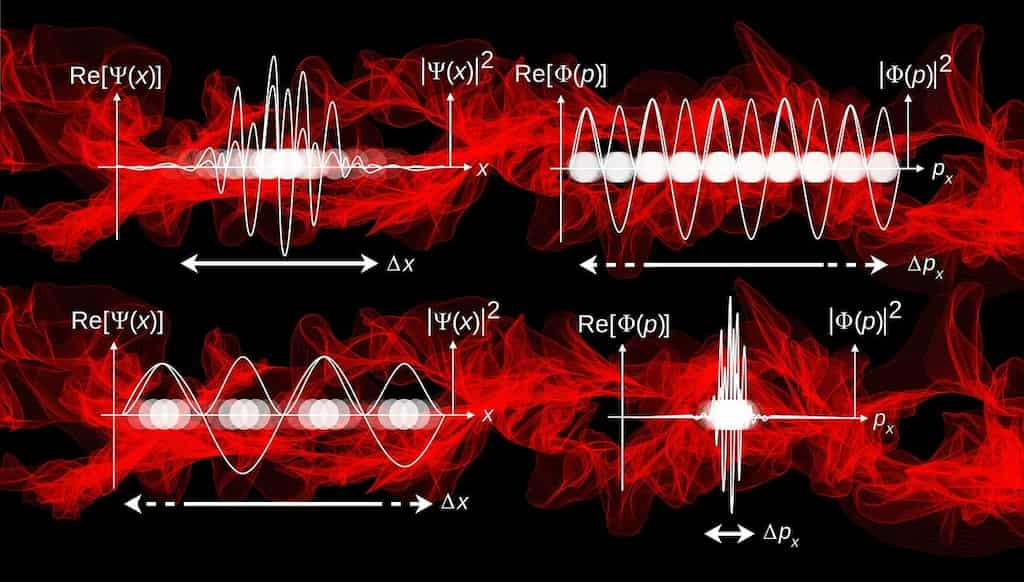

En cualquier proceso termodinámico reversible, se puede representar en cálculo como la integral desde el estado inicial de un proceso hasta su estado final de dQ / T. En un sentido más general, la entropía es una medida de probabilidad y el desorden molecular de un sistema macroscópico.

En un sistema que se puede describir por variables, esas variables pueden asumir un cierto número de configuraciones. Si cada configuración es igualmente probable, entonces la entropía es el logaritmo natural del número de configuraciones, multiplicado por la constante de Boltzmann:S = k

B ln W

donde S es la entropía, k B es la constante de Boltzmann, ln es el logaritmo natural y W representa el número de estados posibles. La constante de Boltzmann es igual a 1.38065 × 10 −23 J / K.

Unidades de entropía

Se considera que la entropía es una propiedad extensa de la materia que se expresa en términos de energía dividida por temperatura. Las unidades SI de entropía son J / K (julios / grados Kelvin).

La entropía y la segunda ley de la termodinámica

Una forma de enunciar la segunda ley de la termodinámica es la siguiente: en cualquier sistema cerrado, la entropía del sistema permanecerá constante o aumentará.

Puede ver esto de la siguiente manera: agregar calor a un sistema hace que las moléculas y los átomos se aceleren. Puede ser posible (aunque complicado) revertir el proceso en un sistema cerrado sin extraer energía o liberar energía en otro lugar para alcanzar el estado inicial. Nunca se puede lograr que todo el sistema sea «menos enérgico» que cuando comenzó. La energía no tiene adónde ir. Para procesos irreversibles, la entropía combinada del sistema y su entorno siempre aumenta.

Conceptos erróneos sobre la entropía

Esta visión de la segunda ley de la termodinámica es muy popular y se ha utilizado incorrectamente. Algunos argumentan que la segunda ley de la termodinámica significa que un sistema nunca puede volverse más ordenado. Esto es falso. S

olo significa que para volverse más ordenado (para que la entropía disminuya), debe transferir energía desde algún lugar fuera del sistema, como cuando una mujer embarazada extrae energía de los alimentos para hacer que el óvulo fertilizado se convierta en un bebé. Esto está completamente en consonancia con las disposiciones de la segunda ley.

La entropía también se conoce como desorden, caos y aleatoriedad, aunque los tres sinónimos son imprecisos.

Entropía absoluta

Un término relacionado es «entropía absoluta», que se denota por S en lugar de ΔS . La entropía absoluta se define de acuerdo con la tercera ley de la termodinámica. Aquí se aplica una constante que hace que la entropía en el cero absoluto se defina como cero.